AI算法黑箱的透明度要求与司法审查标准

例如,《互联网信息服务算法推荐理规定》要求算法备案、科技伦理审查及安全评估检测,确保算法逻辑可追溯。AI算法透明度的核心在于构建“可控、可靠、可用、可信”的治理体系,而司法审查需兼顾技术创新与公共利益。未来需通过动态立法、技术赋能与社会共治,实现算法黑箱的“有限解构”,推动人工智能在法治轨道上健康发展。深度学习模型的“黑箱”特性导致解释困难,需发展可解释AI(XAI)技术,如LIME(局部可解释模

首席数据官高鹏律师团队

一、透明度要求:平衡技术开放与权益保护

1. 技术层面的透明度措施

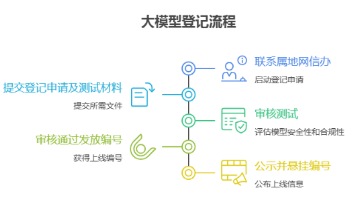

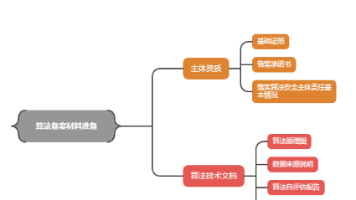

算法备案与审核机制:要求企业提交算法设计文档、数据来源及模型架构,通过备案和动态评估实现全生命周期管理。例如,《互联网信息服务算法推荐理规定》要求算法备案、科技伦理审查及安全评估检测,确保算法逻辑可追溯。

可解释性技术工具:采用特征重要性分析、决策路径可视化等技术,降低算法黑箱的复杂性。例如,知识图谱与强化学习结合可解释推荐系统的决策逻辑。

分级透明度标准:根据算法应用场景的风险等级(如低、中、高),差异化要求透明度。例如,高风险领域(如医疗诊断)需强制披露模型参数,低风险场景可简化说明。

2. 法律与制度层面的透明度规范

赋权与行为规范并重:赋权模式赋予用户算法解释权(如智能投顾的决策依据说明),行为规范模式则通过立法强制企业履行审核义务。

商业秘密与公共利益的平衡:避免以保护商业秘密为由拒绝透明化,需区分核心算法与辅助技术,允许有限披露。

社会共治机制:建立政府、企业、公众参与的敏捷治理框架,例如国家级“司法人工智能伦理委员会”协调技术标准与伦理审查。

二、司法审查标准:合法性、合理性与责任认定

1. 合法性审查

合规性审查:判断算法是否符合数据保护法(如《个人信息保护法》)、反歧视法等。例如,审查算法训练数据是否侵犯隐私,或存在系统性偏见。

授权与程序合法性:验证算法开发是否取得必要许可,如高风险AI系统需通过独立数据库登记备案(欧盟《人工智能法》)。

2. 合理性审查

公平性与非歧视:通过统计分析与模拟测试,检测算法对特定群体的歧视性输出。例如,招聘算法中性别或种族偏见的识别。

透明性验证:要求企业提供算法逻辑的简化说明,而非完整代码。例如,英国建议对“影响重大”的AI系统强制提供可理解的解释。

3. 责任认定与问责机制

因果关系追溯:明确算法错误决策的责任主体,如开发者的技术缺陷或使用者的不当干预。需建立算法审计日志和决策链记录。

动态责任分配:根据算法风险等级划分责任权重。例如,自动驾驶事故中,系统错误与驾驶员疏忽的责任比例需结合算法透明度评估。

三、挑战与应对策略

1. 技术复杂性挑战

深度学习模型的“黑箱”特性导致解释困难,需发展可解释AI(XAI)技术,如LIME(局部可解释模型)和SHAP(Shapley加性解释)。

2. 商业秘密与透明度的冲突

通过“有限透明”策略,允许监管机构获取核心算法细节,但禁止向公众披露,以保护创新激励。

3. 跨学科协作难题

推动法学与计算机科学的交叉研究,建立统一术语体系(如将“证据关联性”映射为“特征相关性”),并加强复合型人才培养。

四、典型案例与实践启示

浙江“大数据杀熟”案:法院要求平台提供算法逻辑说明,最终认定价格歧视成立,凸显透明度在反垄断中的关键作用。

医疗AI误诊纠纷:通过第三方机构复现算法决策路径,验证其是否符合医学规范,推动责任界定从“技术黑箱”向“过程可验”转变。

AI算法透明度的核心在于构建“可控、可靠、可用、可信”的治理体系,而司法审查需兼顾技术创新与公共利益。未来需通过动态立法、技术赋能与社会共治,实现算法黑箱的“有限解构”,推动人工智能在法治轨道上健康发展。

网易易盾是国内领先的数字内容风控服务商,依托网易二十余年的先进技术和一线实践经验沉淀,为客户提供专业可靠的安全服务,涵盖内容安全、业务安全、应用安全、安全专家服务四大领域,全方位保障客户业务合规、稳健和安全运营。

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)