大模型备案怎么做?一篇讲清算法备案与大模型备案的实操指南!要做大模型备案的企业赶紧收藏!

很多企业对“大模型备案”的理解,还停留在“填个表、交个材料”的阶段,这是一个非常典型的误区。事实上,大模型备案并不是简单的材料提交,而是围绕模型能力、数据来源、算法安全、内容风险和组织责任构建的一整套合规体系。如果对备案逻辑理解不清、材料准备方向错误,不仅会影响备案进度,还可能直接影响产品上线、商业合作和后续融资。

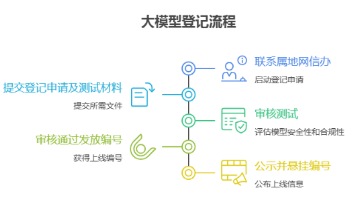

一、什么是大模型备案?企业真正要做的不是一张表

很多企业对“大模型备案”的理解,还停留在“填个表、交个材料”的阶段,这是一个非常典型的误区。事实上,大模型备案并不是简单的材料提交,而是围绕模型能力、数据来源、算法安全、内容风险和组织责任构建的一整套合规体系。如果对备案逻辑理解不清、材料准备方向错误,不仅会影响备案进度,还可能直接影响产品上线、商业合作和后续融资。

本文,目黑老师将从实务与审查视角出发,系统梳理:

企业在大模型备案过程中最容易踩的坑

一套高通过率的大模型备案通常包含哪些核心内容

如何从技术、制度和流程层面提升备案成功率

无论你是大模型产品负责人、AI 创业者、技术负责人,还是正在推进算法备案与上线登记的企业管理者,这篇文章都可以作为一份可直接落地参考的大模型备案实操指南

真实的大模型备案,本质上是:

围绕生成式算法,证明企业已经建立起一套可持续运行的算法安全与合规体系。

这套体系,通常至少覆盖以下四个层面:

-

算法与模型本身的安全控制

-

数据来源与数据处理的合法合规

-

生成内容的风险识别与防控能力

-

企业内部的责任主体、流程与应急机制

换句话说,监管真正关注的不是“你有没有模型”,而是:

你的模型在真实业务中,会不会持续、系统性地产生风险。

二、随着大模型、AIGC 应用在企业中的快速落地,越来越多的公司在真正上线产品、对外提供服务时,都会遇到一个绕不开的问题:

大模型是否需要备案?算法备案和大模型备案到底有什么区别?不备案能不能上线?

如果你正在做以下事情,那么这篇文章对你非常关键:

已经或计划上线大模型产品(Web、API、小程序、App)

使用文生文、文生图、图生文、文生音频等深度合成能力

为客户或内部系统提供 AI 生成内容服务

正在被投资方、合作方、甲方要求补齐合规材料

本文将从实操视角,系统讲清:

大模型备案的核心要求、常见误区、材料组成,以及企业如何低成本、高通过率完成备案。

三、 哪些大模型应用必须重点关注备案问题

从实践经验来看,以下类型的项目,几乎都绕不开备案与合规评估:

1 面向公众或不特定用户的大模型产品

例如智能客服、内容生成平台、营销文案工具、AI 助手等

2 提供 API 接口对外调用的大模型能力

只要不是纯内部封闭使用,就需要重点评估

3 具备明显生成属性的 AI 系统

包括文生文、文生图、图生文、文生音频、图像合成等

4 涉及内容输出、观点表达、图像生成的系统

尤其是营销、教育、咨询、陪伴、创作类场景

如果你的项目已经进入产品化、商业化、对外服务阶段,备案不是“要不要做”的问题,而是“什么时候做、怎么做更稳”的问题。

四 企业在大模型备案中最常踩的几个坑(备案失败高频原因解析)

在大模型备案与算法合规实操过程中,企业被要求补充材料、反复修改、甚至阶段性无法推进备案的情况并不少见。

从大量实际案例来看,问题往往并不出在“没有准备材料”,而是准备方式和监管预期之间存在明显偏差。

以下五个问题,是当前企业在大模型备案过程中最容易踩中的高频雷区,也是备案被反复打回的主要原因。

1 直接套用模板,备案材料高度雷同,极易被识别为高风险

在大模型备案准备阶段,很多企业为了节省时间,往往会选择直接套用通用模板或参考其他企业的备案材料。这种做法在早期看似高效,但在实际审核中,反而是被退回概率最高的一类情况。

原因在于,当前备案审核的关注重点已经从“材料是否齐全”,转向“内容是否真实反映企业实际业务”。

高度模板化的备案材料,通常会暴露出以下问题:

• 模型能力描述泛化,无法体现具体应用场景

• 风险点分析与企业实际产品不匹配

• 多家企业材料中出现高度相似的表述结构和措辞

从审核视角看,这类材料往往难以判断企业是否真正理解并控制自身模型风险,因此会被要求补充说明甚至整体重写。

在大模型备案中,贴合真实业务场景,远比“模板完整度”更重要。

2 只停留在制度层面,缺乏技术可落地性,是典型的“纸面合规”

这是当前大模型备案中,技术团队与合规材料之间最常见的断层问题。

在备案材料中,企业通常会描述:

• 已建立算法安全管理制度

• 已部署内容安全审核机制

• 已制定风险防范和应急处置流程

但在实际审核或进一步沟通中,只要追问到具体实现方式,例如:

• 内容安全审核是自动化还是人工

• 在模型生成的哪个阶段进行控制

• 是否有日志记录和可追溯机制

往往就会发现,制度存在于文档中,但并未真正嵌入系统运行流程。

在大模型备案审核逻辑中,一个非常重要的判断标准是:

制度是否具备可执行性、可验证性和可持续性。

如果制度无法对应到明确的技术实现路径,那么即使文字描述再完善,也会被视为存在较大合规风险。

3 忽略模型评估与测试数据,是大模型备案可信度不足的核心问题

生成内容安全评估与模型测试,是支撑大模型备案的重要技术证据之一,但也是目前很多企业最容易忽视的环节。

在实际备案材料中,常见的问题包括:

• 测试题数量明显不足

• 测试内容缺乏风险分类

• 测试方法描述过于笼统

• 没有形成明确的评估结论

甚至部分材料中,仅简单描述为“已对模型进行安全测试,结果符合要求”,这种表述在审核中几乎不具备任何说服力。

一个具备可信度的大模型备案,通常需要说明:

• 测试题来源与设计原则

• 覆盖的风险类型和场景

• 测试流程和评估方法

• 人工抽检与复核机制

• 最终评估结论和改进措施

缺乏系统性测试数据,会直接影响备案材料的整体可信度。

4 算法安全角色与责任人设置不合理,容易被认为治理能力不足

在大模型备案中,企业内部的组织架构和责任分工,是判断是否具备长期治理能力的重要依据。

但在实际案例中,常见问题包括:

• 算法安全负责人职责模糊,仅为名义角色

• 模型工程师与安全管理职责界限不清

• 内容审核人员缺失或配置明显不足

• 角色设置与企业规模、业务复杂度不匹配

从审核视角看,如果无法明确回答以下问题:

• 谁对模型安全负最终责任

• 谁负责日常风险监测

• 出现问题后由谁牵头处置

那么企业往往会被认为缺乏有效的算法安全治理能力,从而被要求调整组织和职责说明。

5 忽略上线后的持续监测,误把大模型备案当成一次性任务

这是许多企业在观念层面最容易出现的偏差。

大模型备案并不是一次性提交材料后就结束的流程,而是要求企业具备持续运行和持续治理能力。

但在实际操作中,部分企业仅关注备案阶段的材料准备,却忽视了上线后的持续监测与动态管理。

常见问题包括:

• 未明确模型上线后的监测频率

• 缺乏异常输出的识别与记录机制

• 未建立定期评估和复盘流程

从监管逻辑看,一个无法说明“上线后如何持续管理”的系统,本身就存在较高不确定性风险。

因此,在大模型备案中,持续监测能力已经成为判断企业是否具备长期合规运营能力的重要指标。

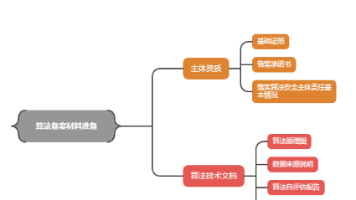

五、 一套高通过率的大模型备案,通常包含哪些核心内容(材料结构全解析)

从实务角度看,高通过率的大模型备案,通常至少包含以下六个核心模块。

⸻

1 算法与模型基本情况说明是备案材料的整体基础

算法与模型基本情况说明,是大模型备案中最基础、也是最容易被低估的一部分内容。

在这一部分中,企业需要清晰说明:

• 模型的类型和技术路线

• 模型具备的主要能力边界

• 实际落地的应用场景

• 服务对象及使用方式

• 明确列出不适用人群和限制条件

需要特别注意的是,监管关注的并不是模型“能做什么”,而是模型被允许做什么。

在实际备案中,常见的问题包括:

• 模型能力描述过于宽泛

• 应用场景与实际产品不一致

• 未明确使用限制和边界

一套高通过率的备案材料,往往会在这一部分明确划清模型能力边界,避免给人“无限泛化”“用途不受控”的印象。

2 训练数据与输入数据合规说明是备案可信度的重要支撑

训练数据和输入数据的合规性,是大模型备案中审查关注度非常高的一部分内容。

在这一模块中,企业通常需要说明:

• 模型训练数据的来源类型

• 数据采集和处理方式

• 是否涉及个人信息或敏感信息

• 数据合法性和合规性控制措施

• 用户输入数据的处理与保护机制

这里的关键点在于:

不是要求披露具体数据内容,而是要说明数据治理逻辑是否清晰、是否可控。

在实际备案中,常见风险点包括:

• 数据来源描述模糊

• 合规措施仅停留在原则层面

• 用户输入数据的处理机制不清

高通过率的备案材料,通常会将训练数据与运行阶段的输入数据区分说明,并明确不同阶段对应的合规控制方式。

3 算法安全管理制度必须与企业真实运行情况相匹配

算法安全管理制度,是体现企业是否具备系统性治理能力的核心模块。

在这一部分中,备案材料通常需要覆盖:

• 信息安全管理制度

• 数据安全管理制度

• 用户个人信息保护制度

• 算法安全管理和风险防控机制

但需要强调的是,制度本身并不是越多越好,而是是否与企业规模、业务形态和技术架构匹配。

在实际审核中,经常会出现以下问题:

• 制度内容与实际系统无法对应

• 制度描述过于理想化

• 多项制度高度模板化

一套高通过率的大模型备案材料,往往会把制度与具体业务流程、系统节点结合说明,让制度看起来是“正在被使用的”,而不是“为了备案而写的”。

4 生成内容安全评估与测试是备案中最关键的技术证据

生成内容安全评估与测试,是大模型备案中直接体现模型风险控制能力的重要依据。

在这一模块中,企业通常需要说明:

• 模型测试的目的和原则

• 测试题的设计逻辑和来源

• 覆盖的风险类型和应用场景

• 人工抽检和复核机制

• 测试结果与评估结论

在实际备案中,生成内容评估部分往往是被重点关注、反复要求补充的内容之一。

常见问题包括:

• 测试题数量不足

• 测试内容缺乏分类

• 没有明确评估结论

高通过率的备案材料,通常会将生成内容评估作为一个独立、成体系的模块来呈现,而不是简单几段概述性说明。

5 风险防范与应急处置机制体现企业对“出问题”的准备程度

风险防范与应急处置机制,是大模型备案中判断企业是否具备应对不确定性能力的重要部分。

在这一模块中,企业通常需要明确说明:

• 如何发现异常或风险输出

• 出现问题后的处置流程

• 是否具备暂停或限制服务的能力

• 责任人和处置权限划分

• 事后复盘与改进机制

监管关注的并不是“会不会出问题”,而是:

一旦出问题,企业是否知道该怎么处理。

如果备案材料中缺乏清晰的应急处置流程,往往会被认为存在较高运行风险。

6 组织架构与责任落实是判断长期治理能力的关键依据

组织架构与责任落实,是大模型备案中经常被忽视,但非常关键的一部分内容。

在这一模块中,企业需要清晰回答三个问题:

• 谁对算法安全负最终责任

• 谁负责日常管理和审核

• 谁在紧急情况下承担兜底职责

在实际案例中,常见问题包括:

• 角色职责描述模糊

• 责任人设置与企业规模不匹配

• 算法安全负责人仅为名义角色

一套高通过率的大模型备案材料,往往会通过清晰的组织结构和职责划分,向审查方传递一个明确的信息:

企业具备长期、稳定运行大模型的治理能力。

5 风险防范与应急处置机制

明确发现问题后的处理流程、责任人和技术手段。

6 组织架构与责任落实

谁负责、谁审核、谁兜底,必须清晰、可执行。

真正专业的备案方案,往往是技术、制度、流程、材料四位一体,而不是单点补齐。

五 为什么越来越多企业选择专业团队协助备案

随着监管要求逐步明确,企业自行摸索备案,往往会面临:

-

时间成本高

-

反复修改

-

风险点识别不全面

-

材料与系统不匹配

专业的大模型备案服务,真正的价值不在于“写材料”,而在于:

-

从业务源头梳理合规边界

-

用工程视角设计可落地方案

-

提前规避高风险结构性问题

-

提升一次性通过率,减少返工

-

wacyltd

对于正在推进产品上线、融资、对外合作的企业来说,合规不是成本,而是确定性。

六 结语:合规不是限制,而是大模型长期发展的前提

大模型行业正在从“能不能做”,走向“能不能长期稳定地做”。

备案不是为了限制创新,而是为了让真正能落地、能负责的企业走得更远。

如果你正在做大模型产品,或即将上线生成式 AI 服务,

越早系统性地解决备案与合规问题,后续的业务空间就越大。

把前沿 AI 技术做得可控、可落地、可上线,

才是大模型真正的护城河。

特别提醒:大模型备案和算法备案,不是“办理许可证”!是通过备案工作,健全企业对模型安全治理的工作!

只有具有大模型合规从业经验者,才能帮助企业以合法合规、没有破绽的形式通过备案!

欢迎运营大模型产品的企业一起交流!

(WeChat: wacyltd | 备注:CSDN)

网易易盾是国内领先的数字内容风控服务商,依托网易二十余年的先进技术和一线实践经验沉淀,为客户提供专业可靠的安全服务,涵盖内容安全、业务安全、应用安全、安全专家服务四大领域,全方位保障客户业务合规、稳健和安全运营。

更多推荐

已为社区贡献12条内容

已为社区贡献12条内容

所有评论(0)